网站 robots.txt 文件配置方法,如何禁止搜索引擎收录指定网站某一篇超链接地址呢,今天跟着麦站一起学学吧。

搜索引擎通过网络蜘蛛抓取网页的内容,并展示在相关的搜索结果中。但是有些网页内容我们可能并不想被搜索引擎收录和索引,如管理员后台等。文章源自张俊SEM-https://zhangjunsem.com/27315.html

我们就可以通过 robots.txt 文件来声明允许/禁止搜索引擎的蜘蛛抓取某些目录或网页,从而限制搜索引擎的收录范围。文章源自张俊SEM-https://zhangjunsem.com/27315.html

文章源自张俊SEM-https://zhangjunsem.com/27315.html

文章源自张俊SEM-https://zhangjunsem.com/27315.html

什么是 robots.txt

Robots是站点与spider沟通的重要渠道,站点通过robots文件声明本网站中不想被搜索引擎收录的部分或者指定搜索引擎只收录特定的部分。文章源自张俊SEM-https://zhangjunsem.com/27315.html

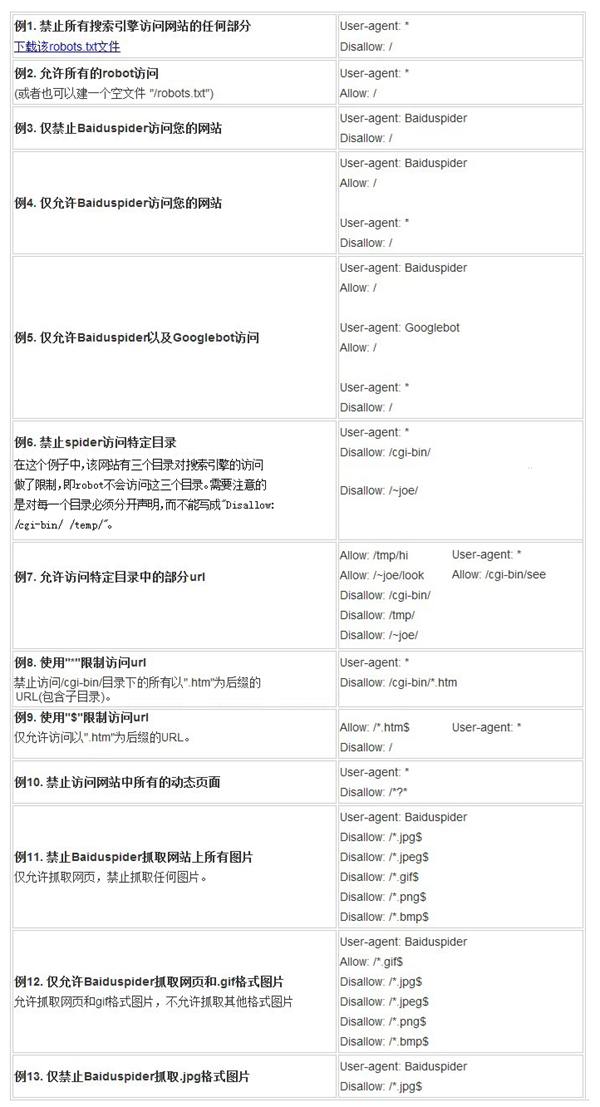

Robots.txt用法:

User-agent:用于指定指令所作用于的目标抓取工具(网络蜘蛛),后接抓取工具名称;文章源自张俊SEM-https://zhangjunsem.com/27315.html

Disallow:指定不允许抓取的目录或网页,后面为空则表示允许抓取一切页面;文章源自张俊SEM-https://zhangjunsem.com/27315.html

Allow:指定允许抓取的目录或网页;文章源自张俊SEM-https://zhangjunsem.com/27315.html

Sitemap:站点地图的位置,必须是绝对路径;文章源自张俊SEM-https://zhangjunsem.com/27315.html

*:表示通配符;文章源自张俊SEM-https://zhangjunsem.com/27315.html

$:表示网址结束;文章源自张俊SEM-https://zhangjunsem.com/27315.html

/:匹配根目录以及任何下级网址。

禁止抓取某一个超链接:

Disallow: /news/hangyejishu/43.html

robots.txt文件用法举例

Robots.txt工具:

http://tool.chinaz.com/robots/

声明:转载此文是出于传递更多学习交流目的。若有来源标注错误或侵犯了您的合法权益,请作者持权属证明与本网联系,我们将及时更正、删除,谢谢。本站部分图文来源于网络,仅供学习交流,发表作品观点仅代表作者本人,本站仅提供信息存储空间服务,不承担连带责任。如有侵权,请及时联系管理员删除。

评论